显微课堂 | 清晰对比、无雾的 3D 样本实时图像

THUNDER技术说明:它们到底是如何工作的

历史上,宽场显微镜并不适合对大样本/标本体积进行成像。图像背景(BG)主要来源于观察样本的失焦区域,显著降低了成像系统的对比度、有效动态范围和最大可能的信噪比(SNR)。记录的图像显示出典型的雾霭,并且在许多情况下,无法提供进一步分析所需的细节水平。处理厚三维样本的研究人员要么使用替代显微镜方法,要么尝试通过后处理一系列图像来减少雾霭。

减少或去除背景(BG)信号的方法

根据处理模糊信号所造成的 BG 的方式,我们区分为排他性和包容性方法。

1

包容性方法

包容性方法,例如宽场(WF)解卷积显微镜,考虑整个体积中的光分布,并将记录的光子从 BG 重新分配到它们的来源,从而提高记录体积的信噪比(SNR)。这种重新分配是可行的,因为来自单个点的光分布由点扩散函数(PSF)描述。随着越来越多的来自模糊层的光与来自聚焦区域的光结合,包容性方法达到了它们的极限。扭曲 PSF 的效应,如光散射,增加了 BG,使得使用包容性方法进行恢复变得更加困难。不幸的是,散射在生物样本中是不可避免的。由于包容性方法根据其定义使用图像中检测到的所有信号,因此它们也处理来自不应对最终结果贡献的模糊层的信号成分。

2

独特方法

包容性方法,例如宽场(WF)解卷积显微镜,考虑整个体积中的光分布,并将记录的光子从 BG 重新分配到它们的来源,从而提高记录体积的信噪比(SNR)。这种重新分配是可行的,因为来自单个点的光分布由点扩散函数(PSF)描述。随着越来越多的来自模糊层的光与来自聚焦区域的光结合,包容性方法达到了它们的极限。扭曲 PSF 的效应,如光散射,增加了 BG,使得使用包容性方法进行恢复变得更加困难。不幸的是,散射在生物样本中是不可避免的。由于包容性方法根据其定义使用图像中检测到的所有信号,因此它们也处理来自不应对最终结果贡献的模糊层的信号成分。

Computational Clearing (CC)

Computational Clearing是THUNDER成像仪的核心技术。它检测并去除每张图像中的失焦背景,使得感兴趣的信号可以直接获取。同时,在清晰聚焦的区域,边缘和样本特征的强度得以保留。当使用基于相机的荧光显微镜记录图像时,“不需要的”背景会与“需要的”清晰结构信号叠加,并且两者总是被记录。为了获得最佳效果,目标是尽可能减少背景。为了从图像中排除不需要的背景,找到准确分离背景与所需信号的关键标准至关重要。一般来说,背景在记录的图像中表现出特征行为,这与其来源无关。因此,仅凭其在图像中的外观,无法辨别背景的来源。特别是在生物样本中,背景通常不是恒定的。它在视场(FOV)中是相当可变的。Computational Clearing自动考虑这一点,使得清晰信号可以立即获取。

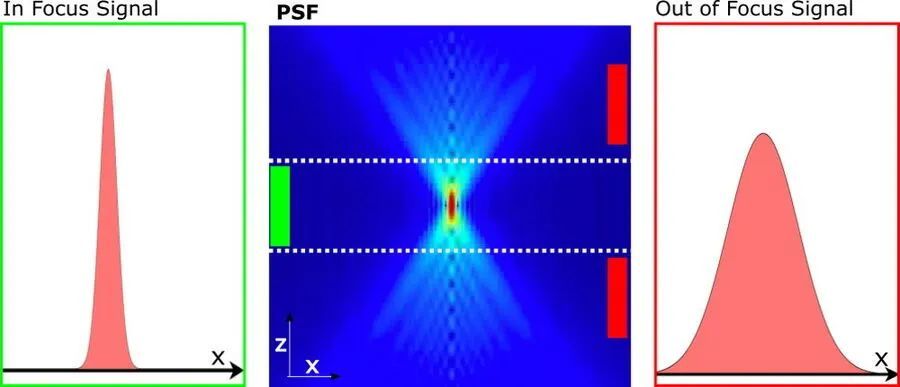

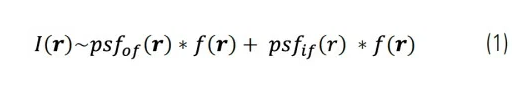

图 1:聚焦和失焦 PSF 的示意图:宽场图像的 PSF(中)可以有效地通过聚焦的两个 PSF 分量(左)和失焦的 PSF 分量(右)来描述。背景估计利用了这样一个事实,即失焦信号的结构长度尺度S[ ̂ Iout] 大于相应的结构长度尺度r0,该尺度由聚焦信号的宽度给出。

使用宽场显微镜获取的图像可以分解为两个组成部分:清晰信号和背景信号。背景信号主要来自失焦信号。因此,宽场图像 I(r) 可以近似表示为:

其中 psfof/if(r) 和 f(r) 分别是清晰(if)和失焦(of)贡献的有效点扩散函数以及荧光分布。由于失焦 PSF 的宽度远大于清晰 PSF,因此在公式 (1) 中,这两个贡献可以通过长度尺度区分算法(例如小波变换)清晰分开。我们开发了一种迭代算法来分离这两个贡献。它在每次迭代中计算以下最小化:

这里S[ ̂Iout]表示估计的失焦贡献的结构长度尺度Iout。结构长度尺度r0(公式 (2))是基于系统的光学参数计算的,并且可以进行调整。在LAS X 软件中,它被称为“特征”尺度。

使用这种方法,仅去除了背景(BG)。保留了来自感兴趣的失焦样本区域的信号和噪声。由于失焦区域的噪声仍然存在,图像中失焦特征的边缘是可见的,因此保持了样本特征与其特征尺度之间的空间关系。尽管生命科学样本中背景的变化特性,特征的相对强度仍然得以保留。

与传统的包容性方法不同,使用Computational Clearing揭示的图像不是生成的,而是从样本中的背景信号中“解锁”的。

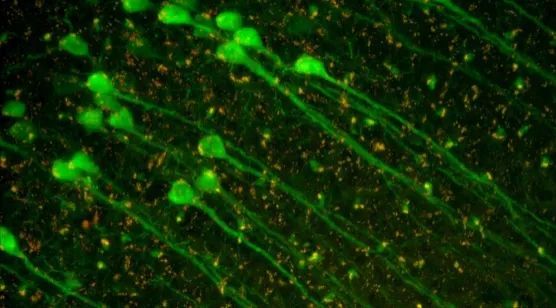

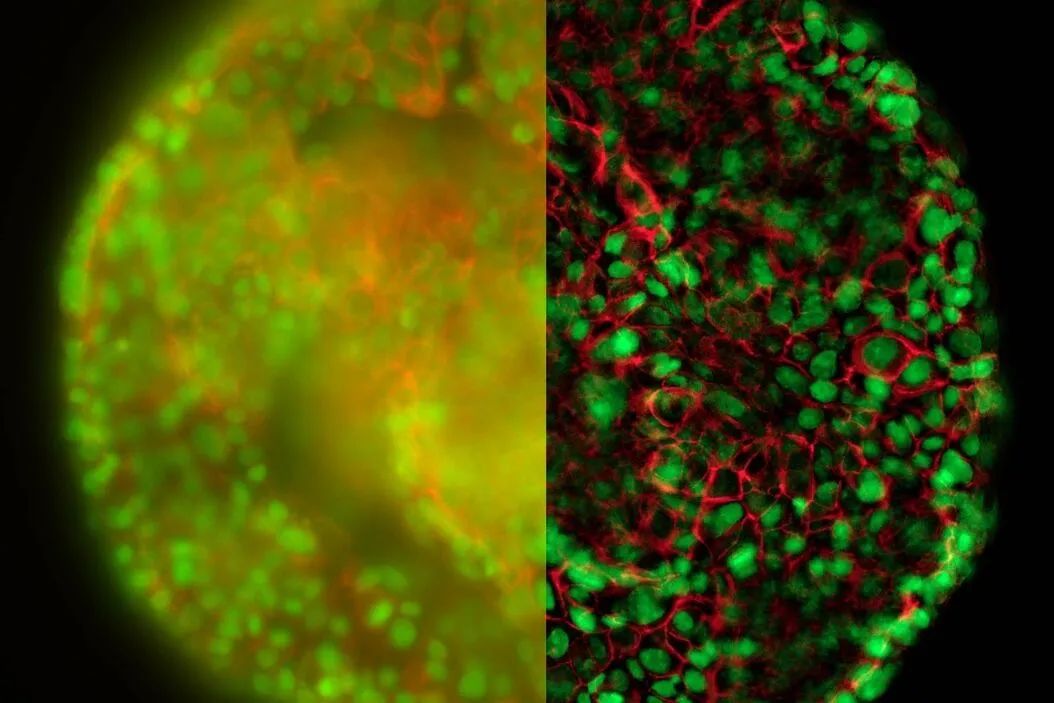

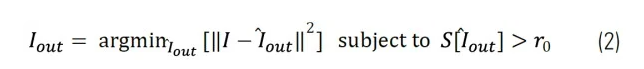

图 2:用 Cy5 标记的βIII 微管大鼠神经细胞显示结构的边缘,这些结构在Computational Clearing后得以保留,以及结果背景。图像是使用THUNDER Imager 3D 细胞培养显微成像系统和 HC PL APO 63x/1.40 油镜头获取的。

Computational Clearing去除了背景,清晰地揭示了样本深处的焦平面。Computational Clearing作为一种独特的方法,实际上在与包容性方法结合使用时变得更加强大。

THUNDER Imager 提供三种模式供选择:

即时Computational Clearing(ICC)

小体积Computational Clearing(SVCC)

大体积Computational Clearing(LVCC)

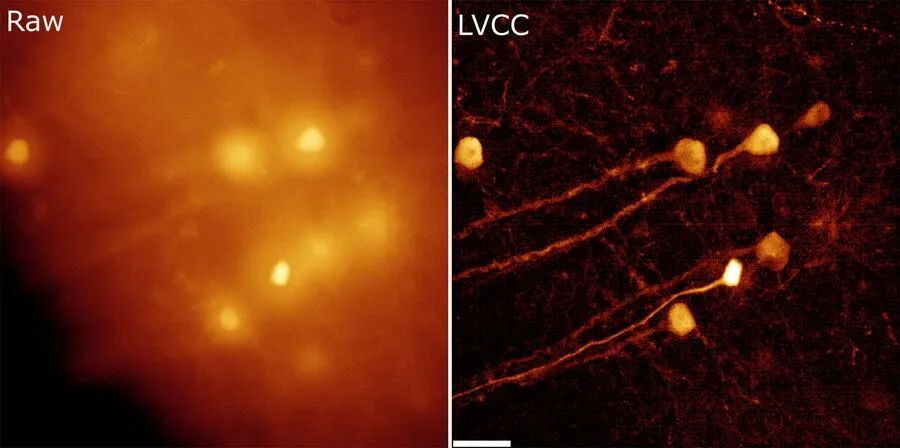

即时Computational Clearing(ICC)是独占Computational Clearing方法的同义词,正如在本技术说明书开头首次介绍的那样。SVCC 和 LVCC 是独占Computational Clearing与基于决策掩模的 3D 去卷积的结合,专门用于薄样品(SVCC)或厚样品(LVCC)。包容性方法的自适应图像信息提取遵循一个概念,该概念源于 LIGHTNING,徕卡显微系统的自适应去卷积方法,最初为共聚焦显微镜开发。

LIGHTNING 使用决策掩模作为基准参考,以计算图像每个体素的适当参数集。结合宽场点扩散函数(PSF),LIGHTNING 固有的完全自动化自适应去卷积过程的功能可以转移到宽场检测中。

实验证据

在本节中,展示了实验数据以证明:

使用THUNDER成像仪生成的数据是可量化的

Computational Clearing如何允许在样本内部更深处成像

使用THUNDER成像仪获得的图像分辨率的改善

量化宽场数据与Computational Clearing I

InSpeck 珠子是微球标准,生成一系列明确定义的荧光强度水平,用于构建校准曲线和评估样品亮度。在这个简短的实验中,将相同体积的同尺寸荧光珠子和非荧光珠子混合在一起。荧光珠子具有不同的相对强度,即 100%、35%、14%、3.7%、1% 和 0.3%。

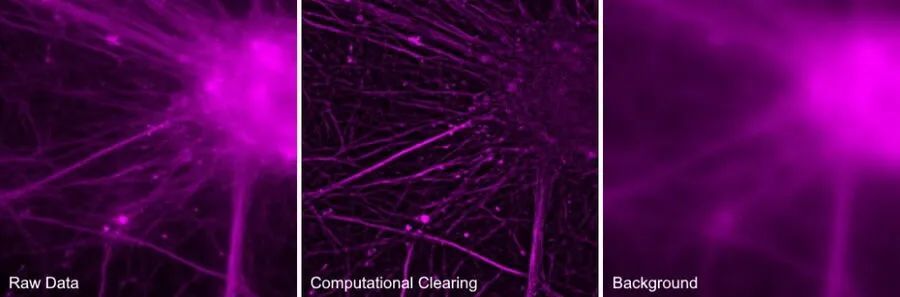

InSpeck 珠子被沉积在载玻片上,并使用 20 倍低 NA 物镜对 156 个位置进行了成像(图 3,单个 z 位置)。记录了三个通道(图 3 从左到右):明场(BF),相位对比(PH)和荧光(FLUO)。FLUO 强度经过调整,以避免明亮物体导致相机传感器饱和。为了纠正潜在的不均匀照明,使用了视场中心区域。

使用了 FOV。没有进行进一步的平场校正。FLUO 图像使用即时Computational Clearing(ICC)进行后处理,特征尺度为 2500 nm,与微珠尺寸一致。

图 3:在单个视场中看到的 InSpeck 珠子。相位对比图像通过阈值处理找到珠子。比例尺:20 微米。

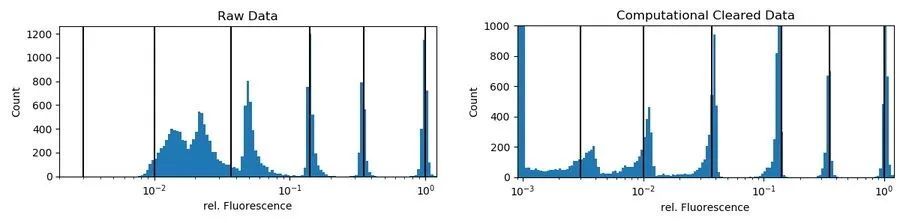

图 4:直方图显示了在原始(左)和 ICC 处理的图像数据(右)中看到的相同特征的相对荧光强度分布。黑线表示基础珠子群体的相对强度。Computational Clearing的数据的比例设置为最大 1,000 计数:第一个区间(零到 0.1%)中有 3,620 计数,代表非荧光珠子。

珠子是通过简单阈值处理 PH 图像找到的。为了纠正错误检测到的珠子,仅接受某一大小(68 到 76 像素)且圆度≥0.99 的圆形物体。该掩膜用于获取原始荧光和 ICC 处理通道的平均强度。没有排除强度异常值。为了获得相对值,所有接受的珠子的原始和处理强度都除以其最大强度群体的中位强度(通常是 100%相对强度的荧光珠子)。在图 4(右)中,黑线显示,经过Computational Clearing后,强度仍然接近预期值。

结论:Computational Clearing技术使得即使是最弱信号群体的真实荧光动态也能被区分,这在原始数据中是不可观察的。使用Computational Clearing技术时,发射强度的量化非常简单。然而,对于此类实验,需要非常严格地遵循定量荧光显微镜的良好实践。

使用Computational Clearing技术量化广域数据 II

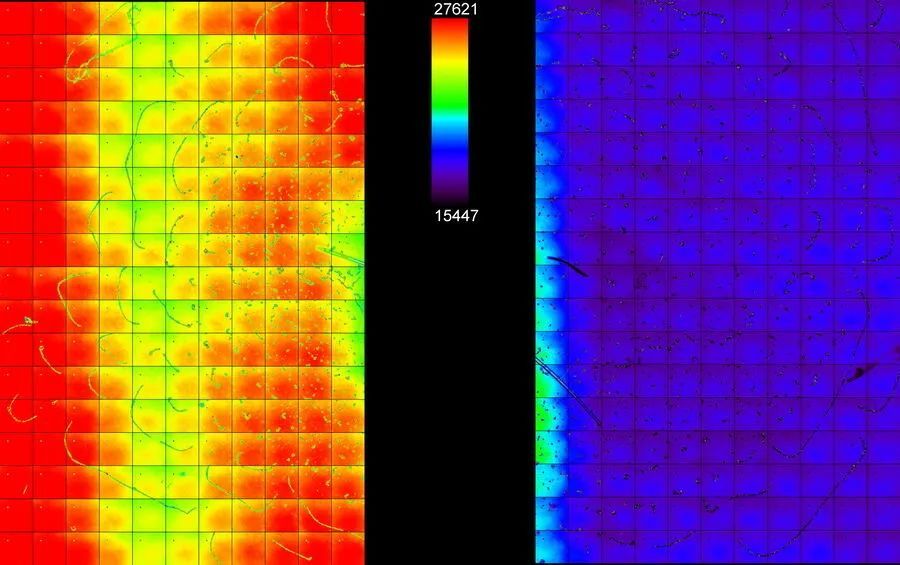

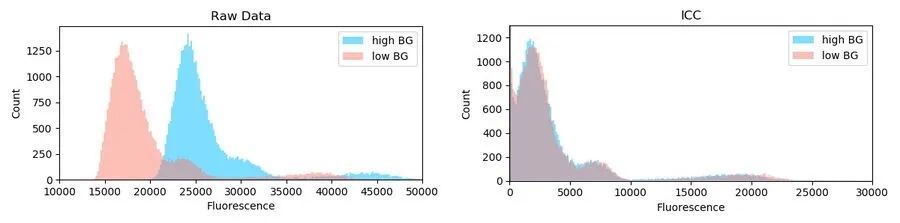

以下实验展示了 ICC 如何处理背景中的巨大差异和异质性。准备了一种不同强度的绿色荧光珠群,并将其分散在载玻片上。珠子以混合强度出现,但呈现出簇状(图 6,左)。通过从滤光块中移除激发滤光片,并用记号笔在载玻片的一半添加荧光素背景,提供了一般背景。定义了两个大小相等的非重叠视场区域:一个在荧光素区域内,即高背景瓷砖扫描(图 5:区域 A,左),另一个在没有荧光素的区域,即低背景瓷砖扫描(图 5:区域 B,右)。

图 5:两个不重叠的瓷砖扫描的合并图像(每个 187 个视场,250 x 250 微米)。左:在高且不均匀背景区域(区域 A)中的瓷砖扫描。右:在低背景区域(区域 B)中的瓷砖扫描。

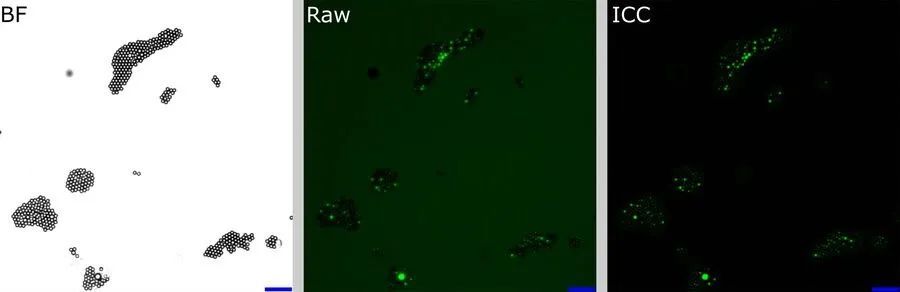

对于每个视场,通过简单的阈值处理 BF 图像(图 6,左)来识别珠子。从这个掩膜中获得原始图像和 ICC 处理图像的平均荧光强度。

图 6:BF 通道的单个视场(左),原始荧光图像(中间)和 ICC 处理图像(右侧)。BF 通道用于分割珠子的中央区域。分割区域用于荧光通道的分析。比例尺:20 微米。原始图像:灰度值从 250,00 到 600,00 的缩放。ICC 图像:灰度值从 0 到 26,000 的缩放。

图 7:在区域 A(高背景,蓝色)和区域 B(低背景,红色)中观察到的物体的强度分布。左侧的直方图显示原始数据,右侧显示 ICC 处理的数据。

不符合特定圆度和大小的物体被丢弃,未用于进一步分析。没有应用其他异常值修正。总共在区域 A(高且不均匀背景)中识别出 39,337 个物体,在区域 B(低背景)中识别出 43,031 个物体。用于后续比较的强度,从区域 A 随机选择 39,337 个物体,以使两个区域的样本大小匹配。

区域 A(高背景)和 B(低背景)中物体的强度分布非常独特(Kolmogorov Smirnov 距离:0.79±0.2,置换重采样)。可以看到一般的偏移和添加的背景(图 7,左侧蓝色)。在Computational Clearing后对数据进行的相同分析显示两个区域的分布非常相似(KS:0.05±0.02)。

结论:Computational Clearing可以处理图像数据中固有的异质背景信号,这些信号在真实生物样本中是普遍存在的。此外,它允许在不需要繁琐的局部背景去除算法的情况下量化荧光信号,这些算法通常需要为每个成像会话进行调整(即使是对于同一物体)。

使用Computational Clearing量化宽场数据 III

为进一步展示 ICC 的线性行为,记录了在固定视场内稳定荧光物体(15 微米珠子)在不同曝光时间下的图像。为了排除照明启动效应,物体始终用激发光照明。由于珠子的低密度和平坦性,原始图像中的背景主要来自相机偏移。ICC 参数根据物体大小设置:15 微米,强度最高(100%)。

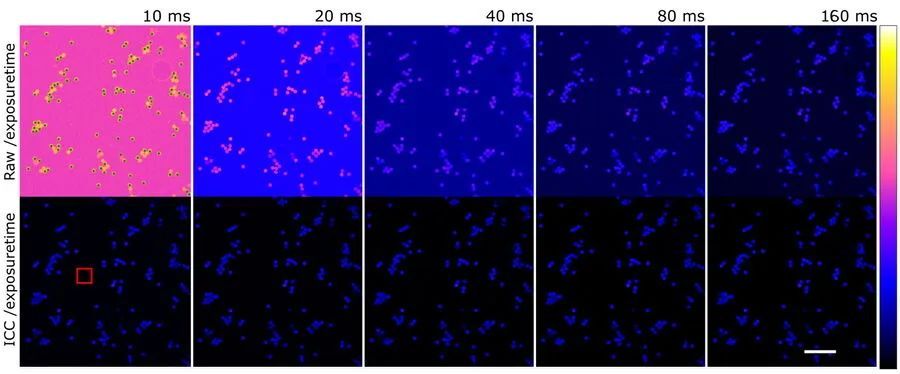

图 8:原始图像(上排)和使用Computational Clearing(下排)在不同曝光时间(列)下拍摄的图像,按各自的曝光时间进行划分。绿色点:用于进一步分析的物体。红色方框:传统背景减法的区域。比例尺:100 微米。

图 8:原始图像(上排)和使用Computational Clearing(下排)在不同曝光时间(列)下拍摄的图像,按各自的曝光时间进行划分。绿色点:用于进一步分析的物体。红色方框:传统背景减法的区域。比例尺:100 微米。

图 9:已识别对象的强度(图 8,绿色点):左侧:原始 ICC 数据,单次测量(灰色)和平均值(红色)。中间:原始强度(蓝色)和使用Computational Clearing技术拍摄的图像(红色)的归一化相对均值(除以曝光时间和 160 毫秒曝光下的值)。阴影表示单个对象值的分布。右侧:Computational Clearing数据与传统背景减去数据的对比,其中添加了一条完美相关性的线(红线)。

最后,ICC 与传统的 BG 减去数据进行了比较。这一步通常是量化强度的必要步骤。计算了每幅图像中无对象区域(100 x 100 像素,如图 8 中红色方框所示)的平均强度,并从同一图像的强度数据中减去。绘制先前找到的对象的平均强度与传统 BG 减去的原始数据的关系。

显示 ICC 给出了相同的结果(图 9,右侧)。结论:ICC 表现出线性行为。它使数据量化成为可能,而无需进一步的图像处理,这在背景异质性较强时尤其繁琐。

可成像的最大深度高度依赖于样本。荧光团的密度、吸收或样本内局部折射率的均匀性等因素直接影响信噪比和每个体素的散射光量。这些因素通常会波动,即使在同一视野内也是如此。

在基于相机的系统中,实现 3D 样本的光学切片的经典方法是使用多点照明,例如使用尼普科盘或网格投影设备。后者在网格无法在焦平面上清晰投影时会引入伪影。另一方面,基于盘的系统必须处理针孔之间的有限距离,这在某些成像深度引入了来自失焦平面的光污染。

通过Computational Clearing,在足够透明的样本中,最大深度主要取决于发射光的散射。Computational Clearing通过去除散射光成分来实现深层成像。如果在图像中至少可以局部获得一些对比度,THUNDER成像仪使其变得可访问。Computational Clearing的一个大优势是它可以与活体标本一起使用,因此成像可以在生理条件下进行。

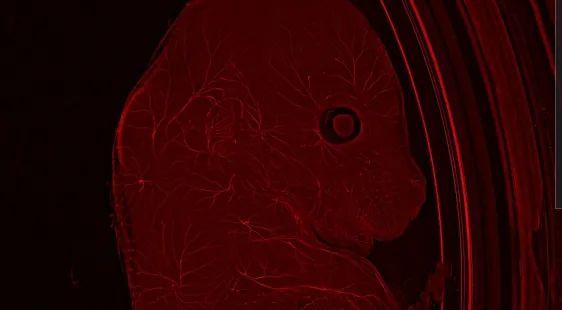

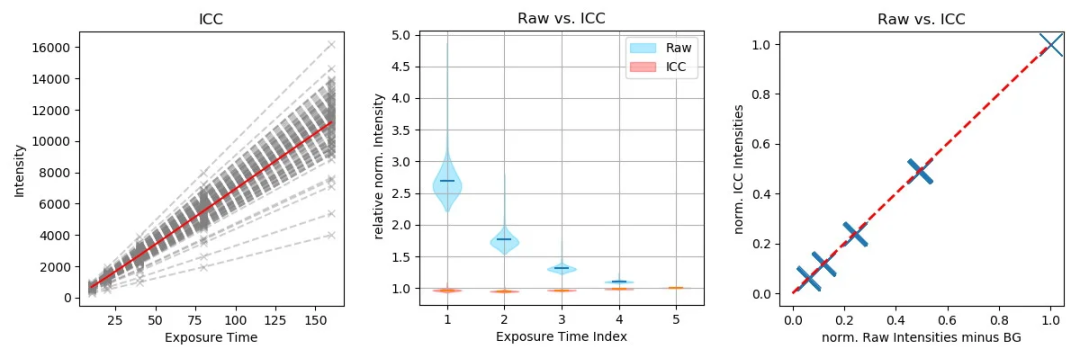

图 10:Computational Clearing的 150 微米脑切片的体积渲染。

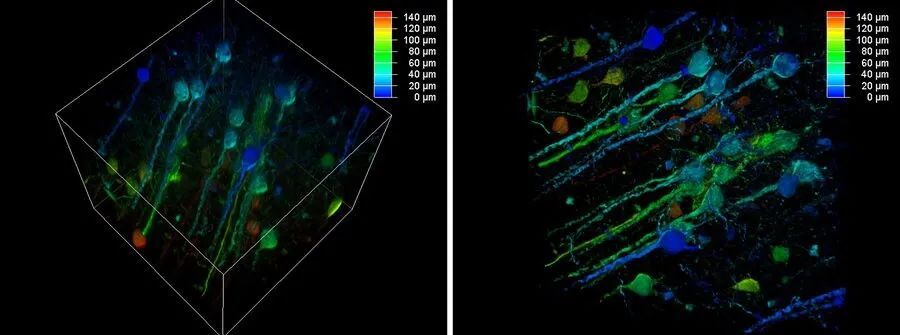

对比噪声比越好,重建结果就越好。对于图 10 中所示的例子,使用了大体积Computational Clearing(LVCC),这是一种Computational Clearing和自适应去卷积的结合,用于成像厚样本体积。在样本的上层,甚至最细微的细节都能被解析并进行分割。尽管在更深层次的分辨率和分割可能会降低,但在样本深度为 140 到 150 微米(图 11)时,显示出大量有价值的细节,这些细节在原始数据中并未显现。没有THUNDER,大多数宽场成像实验在 50 微米的深度就停止,因为人们认为无法获取更多信息。

图 11:深度为 140 到 150 微米的最大强度投影。

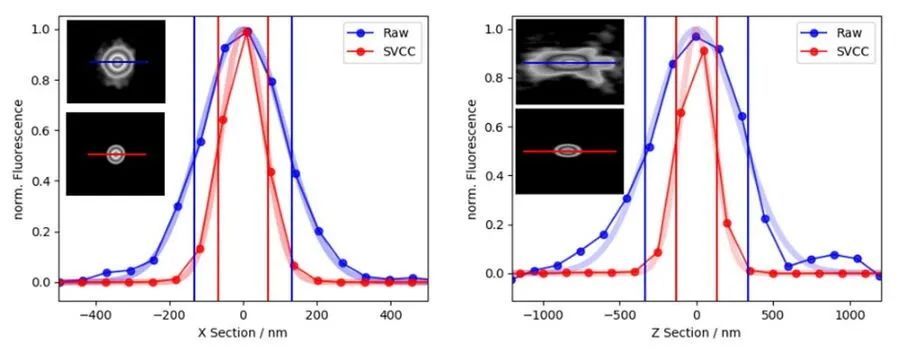

将小体积Computational Clearing(SVCC)应用于单个、非重叠、衍射极限物体会导致分辨率增强,如下图 12 所示。在给定的例子中,成像了一个直径为 40 纳米的单个珠子(100 倍,1.45 NA 物镜),并应用了默认设置的 SVCC。结果是横向分辨率增强* 2 倍(比率 FWHMX SVCC/Raw = 0.51),纵向分辨率增强超过 2.5 倍(比率 FWHMZ SVCC/Raw = 0.39)。

*分辨率增强被定义为发光点源的表观大小。在折射极限以下,无法分离彼此靠近的两个结构。

图 12:单个珠子的 X 轴(左)和 Z 轴(右)强度测量,尺寸低于光学分辨率极限:SVCC 之前(蓝点)和 SVCC 之后(红点)以及拟合的高斯曲线(阴影)。插图显示了相应的 XY 和平面。

摘 要

Computational Clearing是徕卡显微系统的一种独特方法,能够有效区分并消除背景噪声,保留所需信号。它是THUNDER成像仪系列的核心技术。

不同的实验与适当的样本提供了证据,表明Computational Clearing允许对宽场图像进行定量分析。结合自适应去卷积,它可以增强分辨率。THUNDER成像仪允许在大体积样本中进行更深层次的成像,例如组织、模型生物或 3D 细胞培养。THUNDER成像仪是强大的成像解决方案,最大化从 3D 样本中提取的信息。

相关产品

下载THUNDER技术说明书(英文版)

关于徕卡显微系统

更多![]()

邀请函 | 徕卡邀您相约2024年全国电子显微学学术年会

厂商

2024.10.11

阿尔茨海默症(AD)机制研究中的组织及细胞光学成像(下篇)

厂商

2024.10.11

邀请函 | 徕卡邀您参加第十八届中国医师协会神经外科医师年会

厂商

2024.10.11

邀请函 | 徕卡与您相约中华医学会第二十一次耳鼻咽喉头颈外科学术会议

厂商

2024.10.11